System Center Virtual Machine Manager для начинающих

1. Часть №1

Одним из самых распространённых заблуждений о Hyper-V от Microsoft является то, что он считается полностью замкнутым. Давно не является секретом то, что Hyper-V включён в состав операционных систем семейства Windows Server, и что лицензия на Windows Server включает возможность использования Hyper-V и различных средств управления, поставляющихся вместе с ним. В зависимости от используемой версии Windows Server, лицензия на операционную систему может включать лицензии на запуск Windows Server на виртуальных машинах.

На первый взгляд кажется, что всего достаточно для развёртывания и управления виртуальными машинами, но затем может выясниться, что некоторые функции в Windows Server отсутствуют. В некотором смысле, идея о том, что Windows Server включает все, что нужно для Hyper-V, абсолютно верна. Windows Server 2012 R2 позволяет устанавливать Hyper-V, создавать виртуальные машины и управлять ими. Если установлена Windows Server 2012 R2 Standard Edition, то есть лицензия на запуск Windows Server 2012 R2 в качестве гостевой операционной системы на двух виртуальных машинах (при условии, что операционная система хоста не используется ни для чего другого, кроме Hyper-V). Если есть версия Datacenter Edition, то можно запустить Windows Server 2012 R2 на неограниченном количестве виртуальных машин на этом узле Hyper-V. Конечно, даже небольшие организации, как правило, в конечном итоге обнаруживают, что одного сервера Hyper-V недостаточно. Несмотря на то, что на одном сервере Hyper-V может размещаться несколько виртуальных машин, сам хост-сервер может стать единственной точкой отказа. Если хост откажет, то и все работающие на нём виртуальные машины также откажут, что приведёт к длительному простою. Microsoft предлагает два разных метода, которые можно использовать, чтобы избежать этой проблемы. Предпочтительным методом является развёртывание отказоустойчивой кластеризации. Отказоустойчивая кластеризация рассматривает отдельные виртуальные машины как ресурсы кластера. Если хост-сервер потерпел неудачу, кластеризованные виртуальные машины могут переместиться на другой сервер Hyper-V, где они могут продолжить работать.

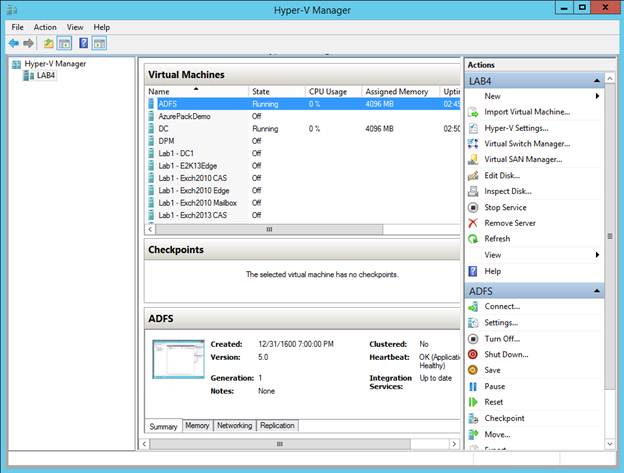

Другим решением по предотвращению превращения сервера Hyper-V в единую точку отказа — создание реплик виртуальный машин. Реплики не обеспечивают отказоустойчивые возможности в режиме реального времени так, как это делает отказоустойчивый кластер, но они позволяют иметь почти актуальную резервную копию виртуальных машин на отдельном сервере Hyper-V. В случае заинтересованности, возможности отказоустойчивого кластеризации доступны через Windows Server (через Диспетчер Отказоустойчивости Кластеров), а функция репликации Hyper-V открывается через Диспетчер Hyper-V. Итак, что может отсутствовать? Одним словом, отсутствует масштабируемость. Диспетчер Hyper-V никогда не был предназначен для масштабирования. Он предназначен для обеспечения представления инфраструктуры виртуализации на уровне хост-сервера. Аналогично, Диспетчера Отказоустойчивости Кластеров также несколько не хватает, когда речь заходит о масштабируемости. Microsoft проделала большую работу с Диспетчером отказоустойчивости Кластеров в Windows Server 2012 R2, чтобы сделать его более масштабируемым. Тем не менее, существуют основные части инфраструктуры виртуализации, которые не отображаются через Диспетчер Отказоустойчивости Кластеров. Именно здесь вступает в работу Диспетчер Виртуальных Машин (Virtual Machine Manager, VMM) System Center 2012 R2, в случаях, когда используется отказоустойчивый кластер, репликация Hyper-V, несколько хостов Hyper-V, или несколько физических серверов. Диспетчер Виртуальных Машин System Center 2012 R2 (далее просто Диспетчер Виртуальных Машин) — это инструмент управления, который предназначен для того, чтобы сделать Hyper-V намного проще для управления этими серверами по мере того, как размер развёртывания Hyper-V увеличивается. Справедливости ради следует отметить, что Диспетчер Виртуальных Машин также предоставляет ряд возможностей Hyper-V, к которым нельзя получить доступ через Диспетчер Hyper-V или через Диспетчер отказоустойчивости Кластеров. О некоторых из этих возможностей будет сказано позже в статье. Сначала поговорим о масштабируемости, потому что Диспетчер Виртуальных Машин изначально был представлен как решение для масштабирования Hyper-V. Чтобы по-настоящему оценить возможности, предоставляемые Диспетчером Виртуальных Машин, взглянем на ограничения, которые присутствуют в Диспетчере Hyper-V. На Рис.1 показан Диспетчер Hyper-V.

|

| Рисунок 1 |

Как показано на рисунке выше, Диспетчер Hyper-V разделен на три вертикальных столбца. В столбце слева указан хост-сервер. В верхней части среднего столбца перечислены все виртуальные машины, которые запущены на хосте. Хотя такая схема кажется достаточно логичной, она несовершенна с точки зрения масштабируемости. Как уже объяснялось ранее, большинство организаций, использующих Hyper-V в производственной среде, имеют более одного сервера Hyper-V. Тем не менее Диспетчер Hyper-V отображает только локальный сервер и работающие на нём виртуальные машины.

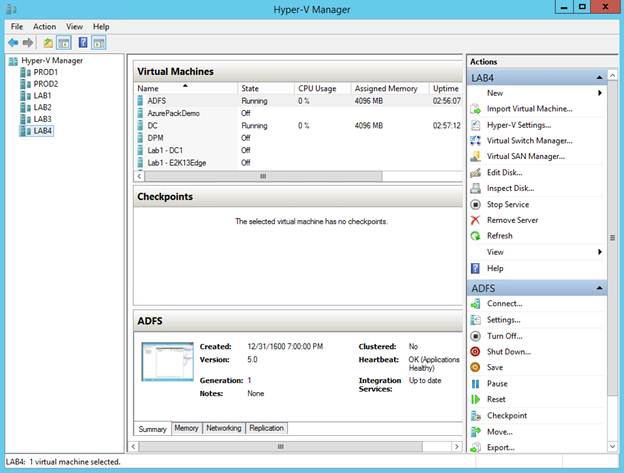

Это не означает, что нет способа ввести в Диспетчер Hyper-V информацию о других хостах Hyper-V. Если желаете, чтобы Диспетчер Hyper-V был в курсе о дополнительных хостах Hyper-V, это можно сделать, нажав правой кнопкой мышки на контейнер Диспетчера Hyper-V (расположенном в верхней левой части консоли) и выбрав команду «Присоединиться к Серверу» из контекстного меню. Таким образом, можно предоставить Диспетчеру Hyper-V имя другого Сервера Hyper-V. Как указано на рисунке ниже, с помощью Диспетчера Hyper-V можно управлять несколькими серверами Hyper-V.

|

| Рисунок 2 |

Хотя в Диспетчере Hyper-V есть возможности управления несколькими серверами, имеются проблемы с использованием Диспетчера Hyper-V для управления крупномасштабными развёртываниями Hyper-V. Во-первых, подключение к различным хостам Hyper-V должно быть установлено вручную. Серверы Hyper-V, показанные на рисунке выше, можно подключить в течение нескольких минут. Даже если это так, представьте, сколько времени займёт процесс (и сколько места возможностей для ошибок или опечаток), если придётся вручную подключать к консоли несколько десятков серверов Hyper-V. Более серьёзная проблема с этим подходом заключается в том, что он не решает проблему масштабируемости. Если посмотреть на рисунок выше, то заметите, что Диспетчер Hyper-V отображает виртуальные машины для текущего выбранного хоста. Итак, что произойдёт, если нужно найти конкретную виртуальную машину? Диспетчер Hyper-V не содержит строки поиска. Переход по памяти также не является вариантом, поскольку виртуальные машины Hyper-V могут динамически мигрировать с одного хост-сервера на другой. Таким образом, хост, на котором вчера была виртуальная машина, может быть не тем же хостом, где находится виртуальная машина сегодня. Если имеется большое количество хост-серверов Hyper-V, и нужно найти определённую виртуальную машину, то есть три варианта. Первый вариант заключается в ручной прокрутке списка виртуальных машин, содержащихся на каждом отдельном хост-сервере. Излишне говорить, что это не очень удобно в больших средах, потому что это занимает много времени и подвержено ошибкам. Второй вариант — использовать Windows PowerShell. Командлет Get-VM можно использовать для поиска виртуальной машины по имени. Хотя этот метод работает очень хорошо, многим администраторам не комфортно работать в PowerShell. Третий вариант — использовать Диспетчер Виртуальных Машин. Диспетчер Виртуальных Машин может предоставить консолидированный вид виртуальных машин на всех хост-серверах. Можно даже использовать Диспетчер Виртуальных Машин для просмотра виртуальных машин, работающих в средах VMware. Теперь после того, как немного поговорили о преимуществах Диспетчера Виртуальных Машин, пришло время начать изучение работы диспетчера виртуальных машин. В следующей части рассмотрим, как установить Диспетчер Виртуальных Машин, и начнём обзор интерфейса Диспетчера Виртуальных Машин.

Управление KVM с помощью Virt-Manager на Windows

Гипервизор KVM идет с отличными утилитами управления для командной строки. Что касается графических программ для управления виртуальными машинами на сервер KVM, то здесь дело обстоит хуже. Под Linux стандартным средством является Virt-Manager. Давайте посмотрим, как можно использовать его под Windows. Стандартная утилита для графического управления гостевыми системами в KVM это virt-manager, который по функционалу сравним с другими управляющими утилитами, например Hyper-V Manager, в части управления виртуальными машины на локальном или удаленном гипервизоре. Нормальной работоспособной версии Virt-Manager или его аналога под операционную систему Windows я пока не встречал. В связи с этим в Windows необходимо использовать для графического управления KVM утилиты, обеспечивающие X11 Forwarding через протокол SSH. В операционной системе Windows необходимо выполнить установку X Window Server, например бесплатный XMing и SSH клиент, например PuTTy . При установке XMing оставляем все параметры по умолчанию и просто нажимаем далее. В конце установке XMing уведомит о возможности запуска в фоновом режиме. Мы с этим соглашаемся. После чего в системном трее появится значок X Window server (XMing) со следующим контекстным меню (скриншот ниже).

Если не выполнять последнюю настройку выше, то при запуске PuTTy можно ввести название нужной утилиты и нажать Enter (скриншот ниже).

Необходимо учитывать, что при закрытии окна Putty, сессия будет разорвана. Источник

Новые возможности System Center Virtual Machine Manager What’s new in System Center Virtual Machine Manager

Эта статья посвящена новым возможностям, поддерживаемым в System Center Virtual Machine Manager 2019 (VMM). This article details the new features supported in System Center 2019 — Virtual Machine Manager (VMM). Кроме того, подробно описываются новые возможности в 2019 UR1 и UR2. Also details the new features in VMM 2019 UR1 and UR2.

Новые возможности в VMM 2019 New features in VMM 2019

В следующих разделах представлены новые возможности Virtual Machine Manager (VMM) 2019. The following sections introduce the new features in Virtual Machine Manager (VMM) 2019.

Среда выполнения приложений Compute

Последовательное обновление для кластеров S2D Cluster rolling upgrade for S2D clusters

Virtual Machine Manager в System Center 2019 поддерживает последовательное обновление кластера узлов локальных дисковых пространств (S2D) с версии Windows Server 2016 до Windows Server 2019. System Center 2019 Virtual Machine Manager supports a rolling upgrade of a Storage Spaces Direct (S2D) host cluster from Windows Server 2016 to Windows Server 2019. Дополнительные сведения см. в разделе Выполнение последовательного обновления. For more information, see Perform a rolling upgrade.

Поддержка дедупликации для тома ReFS Support for deduplication for ReFS volume

VMM 2019 поддерживает дедупликацию для тома ReFS на гиперконвергированном кластере Windows Server 2019 и масштабируемом файловом сервере. VMM 2019 supports deduplication for ReFS volume on the Windows Server 2019 hyper-converged cluster and Scale-Out File Server. Дополнительные сведения см. в разделе Добавление хранилища для узлов и кластеров Hyper-V. For more information, see Add storage to Hyper-V hosts and clusters.

Хранилище Storage

Динамическая оптимизация хранилища Storage dynamic optimization

Эта функция позволяет предотвратить переполнение общего хранилища кластера (общего тома кластера и общих папок) из-за расширения или новых виртуальных жестких дисков (VHD), размещенных в общем хранилище кластера. This feature helps to prevent cluster shared storage (CSV and file shares) from becoming full due to expansion or new virtual hard discs (VHDs) being placed on the cluster shared storage. Теперь можно задать пороговое значение, чтобы активировать предупреждение, если объем свободного пространства в общем хранилище кластера становится ниже порогового значения. You can now set a threshold value to trigger a warning when free storage space in the cluster shared storage falls below the threshold. Такая ситуация может возникнуть во время размещения нового диска. This situation might occur during a new disk placement. Она также может произойти при автопереносе виртуальных жестких дисков в другое общее хранилище в кластере. It also might occur when VHDs are automigrated to other shared storage in the cluster. Дополнительные сведения см. в разделе Динамическая оптимизация. For more information, see Dynamic optimization.

Поддержка мониторинга работоспособности хранилища Support for storage health monitoring

Мониторинг работоспособности хранилища позволяет отслеживать работоспособность и рабочее состояние пула носителей, номеров LUN и физических дисков в структуре VMM. Storage health monitoring helps you to monitor the health and operational status of storage pools, LUNs, and physical disks in the VMM fabric. Вы можете отслеживать работоспособность хранилища на странице Структура в консоли VMM. You can monitor the storage health on the Fabric page of the VMM console. Дополнительные сведения см. в разделе Настройка структуры хранилища VMM. For more information, see Set up the VMM storage fabric.

Сеть Networking

Настройка виртуальных IP-адресов для SLB с помощью шаблонов служб VMM Configuration of SLB VIPs through VMM service templates

В Windows 2016 программно-определяемая сеть (SDN) может использовать программную подсистему балансировки нагрузки (SLB) для равномерного распределения трафика между рабочими нагрузками, которыми управляют поставщики служб и клиенты. Software-defined networks (SDNs) in Windows 2016 can use software load balancing (SLB) to evenly distribute network traffic among workloads managed by service providers and tenants. В настоящее время VMM 2016 поддерживает развертывание виртуальных IP-адресов программной подсистемы балансировки нагрузки с помощью PowerShell. VMM 2016 currently supports deployment of SLB virtual IPs (VIPs) by using PowerShell. В выпуске VMM 2019 поддерживается настройка виртуальных IP-адресов для SLB с помощью шаблонов служб при развертывании многоуровневого приложения. With VMM 2019, VMM supports configuration of SLB VIPs while deploying multitier applications by using the service templates. Дополнительные сведения см. в разделе Настройка виртуальных IP-адресов SLB с помощью шаблонов служб VMM. For more information, see Configure SLB VIPs through VMM service templates.

Настройка зашифрованных сетей виртуальных машин через VMM Configuration of encrypted VM networks through VMM

VMM 2019 поддерживает шифрование для сетей виртуальных машин. VMM 2019 supports encryption of VM networks. С помощью нового компонента зашифрованных сетей можно легко настроить полное шифрование для сетей виртуальных машин с использованием сетевого контроллера. Using the new encrypted networks feature, end-to-end encryption can be easily configured on VM networks by using the network controller. Такое шифрование устраняет риск неавторизованной утечки или изменения трафика между двумя виртуальными машинами в одной сети и одной подсети. This encryption prevents the traffic between two VMs on the same network and the same subnet from being read and manipulated. Управление шифрованием осуществляется на уровне подсети. The control of encryption is at the subnet level. Шифрование можно включить или отключить для каждой подсети сети виртуальной машины. Encryption can be enabled or disabled for each subnet of the VM network. Дополнительные сведения см. в разделе Настройка зашифрованных сетей в SDN с помощью VMM. For more information, see Configure encrypted networks in SDN using VMM.

Поддержка настройки шлюза переадресации уровня 3 с помощью консоли VMM Support for configuring a Layer 3 forwarding gateway by using the VMM console

Переадресация уровня 3 (L3) обеспечивает подключение между физической инфраструктурой в центре обработки данных и виртуализированной инфраструктурой в облаке виртуализации сети Hyper-V. Layer 3 (L3) forwarding enables connectivity between the physical infrastructure in the datacenter and the virtualized infrastructure in the Hyper-V network virtualization cloud. В предыдущих версиях VMM поддерживается настройка шлюза уровня 3 через PowerShell. Earlier versions of VMM supported the Layer 3 gateway configuration through PowerShell. В VMM 2019 шлюз перенаправления уровня 3 можно настроить с помощью консоли VMM. In VMM 2019, you can configure a Layer 3 forwarding gateway by using the VMM console. Дополнительные сведения см. в статье Настройка пересылки уровня 3. For more information, see Configure L3 forwarding.

Поддержка статического MAC-адреса для виртуальных машин, развернутых в облаке VMM Support for a static MAC address on VMs deployed on a VMM cloud

Эта функция позволяет задать статический MAC-адрес для виртуальных машин, развернутых в облаке. With this feature, you can set a static MAC address on VMs deployed on a cloud. Вы также можете изменить MAC-адрес со статического на динамический и наоборот для уже развернутых виртуальных машин. You can also change the MAC address from static to dynamic and vice versa for the already-deployed VMs. Дополнительные сведения см. в разделе Подготовка виртуальных машин в структуре VMM. For more information, see Provision virtual machines in the VMM fabric.

Интеграция с Azure Azure integration

Управление обновлениями виртуальных машин в VMM с использованием подписки службы автоматизации Azure VM update management through VMM by using an Azure automation subscription

В VMM 2019 добавлена возможность исправления и обновления виртуальных машин в локальной среде (под управлением VMM) путем интеграции VMM с подпиской на службу автоматизации Azure. VMM 2019 introduces the possibility of patching and updating on-premises VMs (managed by VMM) by integrating VMM with an Azure automation subscription. Дополнительную информацию см. в разделе Управление виртуальными машинами. For more information, see Manage VMs.

Новая роль RBAC: Администратор виртуальной машины New RBAC role: Virtual Machine Administrator

В ситуации, когда предприятия хотят создать роль пользователя для устранения неполадок, пользователю требуется доступ ко всем виртуальным машинам. In a scenario where enterprises want to create a user role for troubleshooting, the user needs access to all the VMs. Таким образом, пользователь может вносить необходимые изменения на виртуальных машинах, чтобы устранить проблему. In this way, the user can make any required changes on the VMs to resolve a problem. Пользователю также понадобится доступ к структуре, чтобы идентифицировать основную причину возникновения проблемы. There’s also a need for the user to have access to the fabric to identify the root cause for a problem. По соображениям безопасности этому пользователю не нужно предоставлять разрешения на внесение изменений в структуру (например, добавление хранилища или узлов). For security reasons, this user shouldn’t be given privileges to make any changes on the fabric like adding storage or hosts. Текущий контроль доступа на основе ролей (RBAC) в VMM не имеет роли для такого пользователя. The current role-based access control (RBAC) in VMM doesn’t have a role defined for this persona. Существующие роли делегированных администраторов и администраторов структуры имеют слишком мало или много разрешений для устранения неполадок. The existing roles of Delegated Admin and Fabric Admin have too little or more than necessary permissions to perform troubleshooting. Для устранения этой проблемы в VMM 2019 включена поддержка новой роли — администратор виртуальной машины. To address this issue, VMM 2019 supports a new role called Virtual Machine Administrator. Пользователю с этой ролью предоставлены права на чтение и запись для всех виртуальных машин, а в структуре — только право на чтение. The user of this role has Read and Write access to all VMs but Read-only access to the fabric. Дополнительные сведения см. в статье Настройка ролей пользователей в VMM. For more information, see Set up user roles in VMM.

Поддержка групповой управляемой учетной записи службы в качестве учетной записи службы VMM Support for group Managed Service Account as a VMM service account

Групповая управляемая учетная запись службы (gMSA) помогает повысить уровень безопасности. The group Managed Service Account (gMSA) helps improve the security posture. Она обеспечивает удобное автоматическое управление паролями, упрощенное управление именем субъекта-службы и возможность делегирования управления другим администраторам. It provides convenience through automatic password management, simplified service principle name management, and the ability to delegate the management to other administrators. В VMM 2019 поддерживается использование учетных записей gMSA для учетной записи службы сервера управления. VMM 2019 supports the use of gMSA for Management server service account. Дополнительные сведения см. в статье Установка VMM. For more information, see Install VMM. Ниже приведены компоненты или обновления компонентов, представленные в VMM 1807 и включенные в VMM 2019. The following features or feature updates were introduced in VMM 1807 and are included in VMM 2019.

Компоненты, включенные в VMM 2019 и представленные в VMM 1807 Features included in VMM 2019 — introduced in VMM 1807

Хранилище Storage

Поддержка использования общих томов кластера для размещения нового виртуального жесткого диска Supports selection of CSV for placing a new VHD

С помощью VMM можно выбирать общие тома кластера (CSV) для размещения нового виртуального жесткого диска. With VMM, you can select cluster shared volumes (CSVs) for placing a new VHD. В более ранних версиях VMM новый VHD для виртуальной машины по умолчанию размещался в том же общем томе кластера, где находились остальные виртуальные жесткие диски этой виртуальной машины. In earlier versions of VMM, by default a new VHD on a VM is placed on the same CSV where the earlier VHDs associated with the VM are placed. Не было возможности выбрать другой общий том кластера или папку. There was no option to choose a different CSV/ folder. В случае проблем с общим томом кластера, например при исчерпании свободного или выделенного места в хранилище, пользователям приходилось выполнять миграцию VHD-диска после его развертывания. In case of any problems related to the CSV, such as storage that’s full or over commitment, users had to migrate the VHD, but only after they deployed the VHD. В версии VMM 1807 вы можете выбрать любое расположение для нового диска. Вы можете легко управлять этим диском с учетом доступного места в хранилище CSV. With VMM 1807, you can now choose any location to place the new disc. You can manage this disc easily, based on the storage availability of CSVs. Дополнительные сведения см. в разделе Добавление виртуального жесткого диска к виртуальной машине. For more information, see Add a virtual hard disk to a virtual machine.

Сеть Networking

Отображение сведений об LLDP для сетевых устройств Display of LLDP information for networking devices

VMM поддерживает протокол LLDP (Link Layer Discovery Protocol). VMM supports the Link Layer Discovery Protocol (LLDP). Теперь вы можете просмотреть с виртуальной машины сведения о свойствах и возможностях сетевых устройств для узлов. You can now view network device properties and capabilities information of the hosts from VMM. На узлах должна быть установлена ОС Windows 2016 или ее более новая версия. The host operating system must be Windows 2016 or higher.

Для получения свойств LLDP на узлах включены функции DataCenterBridging и DataCenterBridging-LLDP-Tools. DataCenterBridging and DataCenterBridging-LLDP-Tools features have been enabled on hosts to fetch the LLDP properties. Дополнительные сведения см. в разделе Настройка сети для узлов и кластеров Hyper-V в структуре VMM. For more information, see Set up networking for Hyper-V hosts and clusters in the VMM fabric.

Преобразование коммутатора SET в логический коммутатор Convert a SET switch to a logical switch

Вы можете преобразовать коммутатор SET (Switch Embedded Teaming) в логический коммутатор с помощью консоли VMM. You can convert a switch embedded teaming (SET) switch to a logical switch by using the VMM console. В более ранних версиях эта можно было сделать только в сценарии PowerShell. In earlier versions, this feature was supported only through PowerShell script. Дополнительные сведения см. в разделе Создание логических коммутаторов. For more information, see Create logical switches.

Управление узлами VMware VMware host management

VMM поддерживает серверы VMware ESXi версии 6.5 в структуре VMM. VMM supports VMware ESXi v6.5 servers in VMM fabric. Эта поддержка дает администраторам дополнительную гибкость в управлении несколькими используемыми гипервизорами. This support gives administrators additional flexibility in managing multiple hypervisors in use. Сведения о поддерживаемых версиях сервера VMware см. в статье Требования к системе. For more information about supported VMware server versions, see System requirements.

Поддержка обновления кластера S2D Support for S2D cluster update

VMM поддерживает обновление узла или кластера S2D. VMM supports the update of an S2D host or a cluster. Вы можете обновлять отдельные узлы и кластеры S2D до базовых конфигураций, настроенных в службах Windows Server Update Services. You can update individual S2D hosts or clusters against the baselines configured in Windows Server Update Services. Дополнительные сведения см. в разделе Обновление узлов и кластеров Hyper-V. For more information, see Update Hyper-V hosts and clusters.

Прочее Others

Поддержка SQL Server 2017 Support for SQL Server 2017

В VMM поддерживается SQL Server 2017. VMM supports SQL Server 2017. Вы можете обновить SQL Server 2016 до SQL Server 2017. You can upgrade SQL Server 2016 to SQL Server 2017. Ниже приведены компоненты или обновления компонентов, представленные в VMM 1801 и включенные в VMM 2019. The following features or feature updates were introduced in VMM 1801 and are included in VMM 2019.

Компоненты, включенные в VMM 2019 и представленные в VMM 1801 Features included in VMM 2019 — introduced in VMM 1801

Среда выполнения приложений Compute

Вложенная виртуализация Nested virtualization

VMM поддерживает функцию вложенной виртуализации, которая позволяет запускать Hyper-V на виртуальной машине Hyper-V. VMM supports a nested virtualization feature that you can use to run Hyper-V inside a Hyper-V virtual machine. Другими словами, теперь вы можете виртуализировать сам узел Hyper-V. In other words, with nested virtualization, a Hyper-V host itself can be virtualized. Вложенную виртуализацию можно включить по внештатному каналу, используя PowerShell и конфигурацию узла Hyper-V. Nested virtualization can be enabled out-of-band by using PowerShell and Hyper-V host configuration.

Эта возможность позволит вам снизить расходы на инфраструктуру при разработке, тестировании, демонстрации или обучении. You can use this functionality to reduce your infrastructure expense for development, test, demo, and training scenarios. Этот компонент также позволяет использовать решения сторонних производителей для управления виртуализацией с Hyper-V. With this feature, you can also use third-party virtualization management products with Hyper-V. Функцию вложенной виртуализации можно включить или отключить с помощью VMM. You can enable or disable the nested virtualization feature by using VMM. В VMM можно настроить виртуальную машину в качестве узла и выполнять на этой виртуальной машине функции узла. You can configure the VM as a host in VMM and perform host operations from VMM on this VM. Например, динамическая оптимизация VMM рассматривает вложенный узел для размещения виртуальных машин. For example, VMM dynamic optimization considers a nested VM host for placement. Дополнительные сведения см. в разделе Настройка вложенной виртуальной машины в качестве узла. For more information, see Configure a nested VM as a host.

Миграция виртуальной машины VMware (виртуальной машины на основе встроенного ПО EFI) в виртуальную машину Hyper-V Migration of VMware VM (EFI firmware-based VM) to Hyper-V VM

- Виртуальные машины на основе BIOS преобразуются в виртуальные машины Hyper-V поколения 1. BIOS-based VMs are migrated to Hyper-V VM generation 1.

- Виртуальные машины на основе EFI преобразуются в виртуальные машины Hyper-V поколения 2. EFI-based VMs are migrated to Hyper-V VM generation 2.

Также мы внесли улучшения в процесс преобразования виртуальной машины VMWare, ускорив его на 50 %. We’ve also made improvements in the VMWare VM conversion process that makes the conversion up to 50% faster.

Повышение производительности модуля обновления узлов Performance improvement in host refresher

Модуль обновления узлов получил в VMM ряд обновлений для повышения производительности. VMM host refresher has undergone certain updates for performance improvement.

Теперь вы заметите очевидные и значительные улучшения производительности заданий в тех ситуациях, где требуется управление большим количеством узлов и виртуальных машин с контрольными точками. With these updates, in scenarios where an organization manages a large number of hosts and VMs with checkpoints, you can observe significant and noticeable improvements in the performance of the job.

В лаборатории мы добились почти 10-кратного увеличения производительности для экземпляров VMM, управляющих 20 узлами с 45–100 виртуальными машинами в каждом. In our lab with VMM instances managing 20 hosts, and each host managing 45 to 100 VMs, we’ve measured up to 10 times performance improvement.

Расширенный сеанс консоли в VMM Enhanced console session in VMM

Консольное подключение в VMM предоставляет альтернативный вариант подключения к виртуальной машине через удаленный рабочий стол. The console connect capability in VMM provides an alternative way to connect to the VM via remote desktop. Этот метод может пригодиться, когда у виртуальной машины нет сетевых интерфейсов или вы намерены внести изменения конфигурации, которые могут нарушить сетевое подключение. This method is most useful when the VM doesn’t have any network connectivity or when you want to change to a network configuration that could break the network connectivity. В настоящее время консольное подключение в VMM поддерживает только базовые функции сеанса и позволяет вставлять текст из буфера только через пункт меню Ввести текст из буфера обмена. Currently, the console connect capability in VMM supports only a basic session where clipboard text can be pasted only by using the Type Clipboard Text menu option.

VMM поддерживает режим расширенного сеанса, в котором становятся доступны операции буфера обмена Вырезать (CTRL+X) , Копировать (CTRL+C) и Вставить (CTRL+V) для текста и файлов в кодировке ANSI. VMM supports an enhanced console session that enables Cut (Ctrl + X), Copy (Ctrl + C), and Paste (Ctrl + V) operations on the ANSI text and files available on the clipboard. В результате можно выполнять команды Копировать и Вставить для текста и файлов с виртуальной машины и в нее. As a result, Copy and Paste commands for text and files are possible from and to the VM. Дополнительные сведения см. в разделе Включение расширенного сеанса консоли в VMM. For more information, see Enable enhanced console session in VMM.

Хранилище Storage

Улучшение системы качества обслуживания хранилища в VMM Improvement in VMM storage QoS

Система качества обслуживания хранилища (SQoS) позволяет централизованно отслеживать и контролировать производительность хранилища для виртуальных машин с помощью ролей Hyper-V и масштабируемого файлового сервера. Storage Quality of Service (QoS) provides a way to centrally monitor and manage storage performance for virtual machines by using Hyper-V and the Scale-Out File Server roles. Этот компонент автоматически улучшает равномерность распределения ресурсов хранилища между несколькими виртуальными машинами в одном кластере. The feature automatically improves storage resource fairness between multiple VMs by using the same cluster. Он также обеспечивает достижение целевых показателей производительности на основе политик. It also allows policy-based performance goals.

VMM поддерживает следующие усовершенствования в качестве обслуживания хранилища. VMM supports the following improvements in storage QoS:

- Расширение поддержки качества обслуживания хранилища за пределы S2D. Теперь политики качества обслуживания хранилища можно назначить для сетей хранения данных (SAN). Extension of storage QoS support beyond S2D: You can now assign storage QoS policies to storage area networks (SANs). Дополнительные сведения см. в статье Управление качеством обслуживания хранилища в кластерах. For more information, see Manage storage QoS for clusters.

- Поддержка частных облаков VMM. Теперь клиенты облака VMM могут использовать политики качества обслуживания хранилища. Support for VMM private clouds: Storage QoS policies can now be consumed by the VMM cloud tenants. Дополнительные сведения см. в разделе Создание частного облака. For more information, see Create a private cloud.

- Доступность политик качества обслуживания хранилища в качестве шаблонов. Политики качества обслуживания хранилища можно задать с помощью шаблонов виртуальных машин. Availability of storage QoS policies as templates: You can set storage QoS policies through VM templates. Дополнительные сведения см. в статье Добавление шаблонов виртуальных машин в библиотеку VMM. For more information, see Add VM templates to the VMM library.

Сеть Networking

Настройка гостевых кластеров в SDN с помощью VMM Configuration of guest clusters in SDN through VMM

Настройка гостевых кластеров в Windows Server 2016 и System Center 2016 претерпела ряд изменений с появлением программно-определяемой сети. With the advent of the software-defined network in Windows Server 2016 and System Center 2016, the configuration of guest clusters has undergone some change.

Теперь, когда появились сети SDN, подключенные к виртуальной сети через SDN виртуальные машины могут использовать только тот IP-адрес, который сетевой контроллер назначит для обмена данными. With the introduction of the SDN, VMs that are connected to the virtual network by using SDN are only permitted to use the IP address that the network controller assigns for communication. Структура SDN основывается на структуре сети Azure и поддерживает функцию плавающего IP-адреса через программную подсистему балансировки нагрузки (SLB), как и в сетях Azure. The SDN design is inspired by Azure networking design and supports the floating IP functionality through the software load balancer (SLB) like Azure networking.

VMM поддерживает функцию плавающих IP-адресов через SLB при работе с SDN. VMM also supports the floating IP functionality through the SLB in the SDN scenarios. VMM 1801 поддерживает гостевые кластеры через виртуальные IP-адреса внутренней подсистемы балансировки нагрузки (ILB). VMM 1801 supports guest clustering through an internal load balancer (ILB) VIP. Внутренняя подсистема балансировки нагрузки использует порты проверки, которые создаются на виртуальных машинах в гостевом кластере для идентификации активного узла. The ILB uses probe ports, which are created on the guest cluster VMs to identify the active node. В любой момент порт пробы только активного узла отвечает на ILB. At any given time, the probe port of only the active node responds to the ILB. Затем весь трафик, направленный на виртуальный IP-адрес, направляется на активный узел. Then all the traffic directed to the VIP is routed to the active node. Дополнительные сведения см. в разделе Настройка гостевых кластеров в SDN с помощью VMM. For more information, see Configure guest clusters in SDN through VMM.

Настройка виртуальных IP-адресов для SLB с помощью шаблонов служб VMM Configuration of SLB VIPs through VMM service templates

В Windows 2016 сеть SDN может использовать SLB для равномерного распределения трафика между рабочими нагрузками, которыми управляют поставщики служб и клиенты. SDN in Windows 2016 can use SLB to evenly distribute network traffic among workloads managed by service provider and tenants. В настоящее время VMM 2016 поддерживает развертывание виртуальных IP-адресов программной подсистемы балансировки нагрузки с помощью PowerShell. VMM 2016 currently supports deployment of SLB VIPs by using PowerShell.

VMM поддерживает настройку виртуальных IP-адресов для SLB с помощью шаблонов служб при развертывании многоуровневого приложения. VMM supports configuration of SLB VIPs when you deploy multitier applications by using the service templates. Дополнительные сведения см. в разделе Настройка виртуальных IP-адресов SLB с помощью шаблонов служб VMM. For more information, see Configure SLB VIPs through VMM service templates.

Настройка зашифрованных сетей виртуальных машин через VMM Configuration of encrypted VM networks through VMM

VMM поддерживает шифрование для сетей виртуальных машин. VMM supports encryption of VM networks. С помощью нового компонента зашифрованных сетей можно легко настроить полное шифрование для сетей виртуальных машин с использованием сетевого контроллера. Using the new encrypted networks feature, end-to-end encryption can be easily configured on VM networks by using the network controller. Такое шифрование устраняет риск неавторизованной утечки или изменения трафика между двумя виртуальными машинами в одной сети и одной подсети. This encryption prevents traffic between two VMs on the same network and same subnet from being read and manipulated.

Управление шифрованием осуществляется на уровне подсети. The control of encryption is at the subnet level. Шифрование можно включить или отключить для каждой подсети сети виртуальной машины. Encryption can be enabled or disabled for each subnet of the VM network. Дополнительные сведения см. в разделе Настройка зашифрованных сетей в SDN с помощью VMM. For more information, see Configure encrypted networks in SDN using VMM.

Безопасность Security

Поддержка экранированных виртуальных машин Linux Support to Linux shielded VMs

В Windows Server 2016 реализована концепция экранированной виртуальной машины для виртуальных машин Windows. Windows Server 2016 introduced the concept of a shielded VM for Windows OS-based VMs. Экранированные виртуальные машины защищают от вредоносных действий администратора. Shielded VMs protect against malicious administrator actions. Они обеспечивают защиту, когда данные виртуальной машины находятся в неактивном состоянии или когда на узлах Hyper-V выполняется ненадежное программное обеспечение. They provide protection when the VM’s data is at rest or when untrusted software runs on Hyper-V hosts.

В Windows Server версии 1709 для Hyper-V появилась поддержка подготовки экранированных виртуальных машин Linux. With Windows Server 1709, Hyper-V introduces support for provisioning Linux shielded VMs. Эта же поддержка теперь предоставляется для VMM. The same support is now extended to VMM. Дополнительные сведения см. в разделе Создание диска с шаблоном экранированной виртуальной машины Linux. For more information, see Create a Linux shielded VM template disk.

Настройка резервной HGS Configuration of fallback HGS

Служба защиты узлов (HGS) предоставляет службы аттестации и защиты ключей для запуска экранированных виртуальных машин на узлах Hyper-V. The host guardian service (HGS) provides attestation and key protection services to run shielded VMs on Hyper-V hosts. Она должна работать даже в ситуациях сбоя. It should operate even in situations of disaster. В Windows Server 1709 добавлена поддержка резервной HGS. Windows Server 1709 added support for fallback HGS.

VMM позволяет настроить для защищенного компьютера сразу две пары (URI аттестации и защиты ключей) URL-адресов HGS — основную и дополнительную. Using VMM, a guarded host can be configured with a primary and a secondary pair of HGS URLS (an attestation and key protection URI). Эта возможность позволяет реализовать такие сценарии, как развертывание защищенной структуры сразу в двух центрах обработки данных в целях аварийного восстановления и выполнение HGS на экранированной виртуальной машине. This capability enables scenarios such as guarded fabric deployments that span two datacenters for disaster recovery purposes and HGS running as shielded VMs.

URL-адреса основной службы HGS всегда имеют преимущество перед дополнительными. The primary HGS URLs are always used in favor of the secondary HGS URLs. Если основная служба HGS не сможет ответить по прошествии установленного времени ожидания и количества повторных попыток, выполняется попытка обращения к дополнительной службе. If the primary HGS fails to respond after the appropriate timeout and retry count, the operation is reattempted against the secondary HGS. Последующие операции всегда предпочитают основную службу. Subsequent operations always favor the primary. Дополнительная служба используется только в случае сбоя основной. The secondary is used only when the primary fails. Дополнительные сведения см. в разделе Настройка резервных URL-адресов службы HGS в VMM. For more information, see Configure HGS fallback URLs in VMM.

Интеграция с Azure Azure integration

Управление подписками Azure на основе Azure Resource Manager и региона Management of Azure Resource Manager-based and region-specific Azure subscriptions

В настоящее время подключаемый модуль Azure для VMM поддерживает только классические виртуальные машины и глобальные регионы Azure. Currently, the VMM Azure plug-in supports only classic VMs and global Azure regions.

VMM 1801 поддерживает управление следующими элементами. VMM 1801 supports management of:

- Виртуальные машины на базе Azure Resource Manager. Azure Resource Manager-based VMs.

- Проверка подлинности на основе Azure Active Directory, созданная с помощью нового портал Azure. Azure Active Directory-based authentication that’s created by using the new Azure portal.

- Подписки Azure для некоторых регионов, а именно регионы Azure для правительств Германии, Китая и США. Region-specific Azure subscriptions, namely, Germany, China, and US Government Azure regions.

Дополнительную информацию см. в разделе Управление виртуальными машинами. For more information, see Manage VMs.

Новые возможности в VMM 2019 UR1 New features in VMM 2019 UR1

В следующих разделах представлены новые компоненты или обновления компонентов, поддерживаемые в накопительном пакете обновления 1 (UR1) VMM 2019. The following sections introduce the new features or feature updates supported in VMM 2019 Update Rollup 1 (UR1).

Сведения о проблемах, которые были устранены в UR1, и инструкции по установке для UR1 см. в этой статье базы знаний. For problems fixed in UR1, and the installation instructions for UR1, see the KB article.

Среда выполнения приложений Compute

Поддержка управления реплицированными общими папками библиотек Support for management of replicated library shares

Крупные предприятия, как правило, имеют многосайтовые развертывания центров обработки данных для обслуживания различных офисов по всему миру. Large enterprises usually have multisite datacenter deployments to cater to various offices across the globe. Эти предприятия обычно имеют локально доступный сервер библиотеки для доступа к файлам для развертывания виртуальной машины, а не для доступа к общим папкам библиотеки из удаленного расположения. These enterprises typically have a locally available library server to access files for VM deployment rather than accessing the library shares from a remote location. Это позволяет избежать проблем, связанных с сетью, которые могут возникнуть у пользователей. This arrangement is to avoid any network-related problems users might experience. Но для обеспечения однородных развертываний виртуальных машин файлы библиотек должны быть согласованы во всех центрах обработки данных. But library files must be consistent across all the datacenters to ensure uniform VM deployments. Чтобы обеспечить единообразие содержимого библиотеки, организации используют технологии репликации. To maintain uniformity of library contents, organizations use replication technologies.

VMM теперь поддерживает управление серверами библиотек, которые реплицируются. VMM now supports the management of library servers, which are replicated. Для управления реплицированными общими ресурсами с помощью VMM можно использовать любые технологии репликации, такие как DFSR. You can use any replication technologies, such as DFSR, and manage the replicated shares through VMM. Дополнительные сведения см. в разделе Управление реплицированными общими папками библиотеки. For more information, see Manage replicated library shares.

Хранилище Storage

Настройка параметров DCB в кластерах S2D Configuration of DCB settings on S2D clusters

RDMA и мостовые соединения центров обработки данных (DCB) помогают достичь уровня производительности и отсутствия потери данных в сети Ethernet аналогично уровню сетей оптоволоконного канала. Remote Direct Memory Access (RDMA) and data center bridging (DCB) help to achieve a similar level of performance and losslessness in an Ethernet network as in fiber channel networks.

VMM 2019 UR1 поддерживает настройку мостового соединения для центра обработки данных в кластерах S2D. VMM 2019 UR1 supports configuration of DCB on S2D clusters.

Необходимо одинаково настроить параметры DCB для всех узлов и сети структуры (коммутаторы). You must configure the DCB settings consistently across all the hosts and the fabric network (switches). Неправильно настроенный параметр DCB на любом устройстве узла или структуры отрицательно сказывается на производительности S2D. A misconfigured DCB setting in any one of the host or fabric devices is detrimental to the S2D performance. Дополнительные сведения см. в разделе Настройка параметров DCB в кластере S2D. For more information, see Configure DCB settings on the S2D cluster.

Сеть Network

Улучшенное взаимодействие с пользователем в логических сетях User experience improvements in logical networks

В VMM 2019 UR1 пользовательский интерфейс улучшен для процесса создания логических сетей. In VMM 2019 UR1, the user experience is enhanced for the process of creating logical networks. Логические сети теперь группируются в описании продукта на основе вариантов использования. Logical networks are now grouped by product description based on use cases. Кроме того, приведена иллюстрация для каждого типа логической сети и схема зависимостей. Also, an illustration for each logical network type and a dependency graph are provided. Дополнительные сведения см. в разделе Настройка логических сетей в структуре VMM 2019 UR1. For more information, see Set up logical networks in the VMM 2019 UR1 fabric.

Дополнительные параметры для включения вложенной виртуализации Additional options to enable nested virtualization

Теперь вложенную виртуализацию можно включить при создании новой виртуальной машины и развертывании виртуальных машин с помощью шаблонов виртуальных машин и шаблонов служб. You can now enable nested virtualization while you create a new VM and deploy VMs through VM templates and service templates. В более ранних выпусках вложенная виртуализация поддерживалась только на развернутых виртуальных машинах. In earlier releases, nested virtualization is supported only on deployed VMs. Дополнительные сведения см. Настройка вложенной виртуальной машины в качестве узла. Learn more about enabling nested virtualization.

Обновления командлетов PowerShell Updates to PowerShell cmdlets

VMM 2019 UR1 включает следующие обновления командлетов для соответствующих функций: VMM 2019 UR1 includes the following cmdlet updates for the respective features:

Настройка параметров DCB в кластерах S2D Configuration of DCB settings on S2D clusters

Новый командлет New-SCDCBSettings — настраивает параметры DCB в кластере S2D, управляемом VMM. New cmdlet New-SCDCBSettings — configures DCB settings in the S2D cluster managed by VMM.

Новый параметр [-DCBSettings] — задает параметры DCB, настроенные на кластере, и включен в командлеты Install-SCVMHostCluster, Set-SCVMHostCluster и Set-SCStorageFileServer. New parameter [-DCBSettings] — specifies the DCB settings configured on the cluster, and is included in Install-SCVMHostCluster, Set-SCVMHostCluster and Set-SCStorageFileServer cmdlets.

Дополнительные параметры для включения вложенной виртуализации Additional options to enable nested virtualization

- Новый параметр [-EnableNestedVirtualization] — включает вложенную виртуализацию и включен в командлет Set-SCComputerTierTemplate. New parameter [-EnableNestedVirtualization] — enables the nested virtualization, and is included in Set-SCComputerTierTemplate cmdlet.

Дополнительные сведения об этих обновлениях см. в статьях, посвященных VMM PowerShell. For more information about these updates, see VMM PowerShell articles.

Новые возможности в VMM 2019 UR2 New features in VMM 2019 UR2

В следующих разделах представлены новые компоненты или обновления компонентов, поддерживаемые в накопительном пакете обновления 2 (UR2) VMM 2019. The following sections introduce the new features and feature updates supported in VMM 2019 Update Rollup 2 (UR2).

Сведения о проблемах, которые были устранены в VMM 2019 UR2, и инструкции по установке для UR2 см. в этой статье базы знаний. For problems fixed in VMM 2019 UR2, and installation instructions for UR2, see the KB article.

Службы вычислений Compute

Поддержка узлов Windows Server 2012 R2 Support for Windows Server 2012 R2 hosts

В VMM 2019 UR2 поддерживаются узлы Windows Server 2012 R2. VMM 2019 UR2 supports windows server 2012 R2 hosts. Сведения о поддерживаемых узлах см. в статье Требования к системе. For more information about the supported hosts, see System requirements.

Поддержка узлов ESXi 6.7 Support for ESXi 6.7 hosts

VMM 2019 UR2 поддерживает серверы VMware ESXi версии 6.7 в структуре VMM. VMM 2019 UR2 supports VMware ESXi v6.7 servers in VMM fabric. Эта поддержка дает администраторам дополнительную гибкость в управлении несколькими используемыми гипервизорами. This support gives additional flexibility to the administrators in managing multiple hypervisors in use. Сведения о поддерживаемых версиях сервера VMware см. в статье Требования к системе. For more information about supported VMware server versions, see System requirements.

Сеть Networking

Улучшенное взаимодействие с пользователем при создании логических коммутаторов User experience improvements in creating logical switches

В VMM 2019 UR2 пользовательский интерфейс улучшен для процесса создания логических коммутаторов. With VMM 2019 UR2, the user experience is enhanced for the process of creating logical switches. 2019 UR2 содержит интеллектуальные значения по умолчанию, предоставляет четкие текстовые пояснения для различных параметров, визуальные представления, а также схему топологии для логического коммутатора. 2019 UR2 includes smart defaults, provides clear text explanation for various options along with visual representations, and a topology diagram for logical switch. Подробнее. Learn more.

Поддержка протокола IPv6 Support for IPv6

В VMM 2019 UR2 поддерживается развертывание IPv6 SDN. VMM 2019 UR2 supports IPv6 SDN deployment. Подробнее. Learn more.

Настройка сходства между виртуальными и физическими сетевыми адаптерами Provision to set affinity between virtual network adapters and physical adapters

В VMM 2019 UR2 поддерживается сходство между виртуальными и физическими сетевыми адаптерами. VMM 2019 UR2 supports affinity between vNICs and pNICs. Сходство между виртуальными и физическими сетевыми адаптерами обеспечивает гибкость маршрутизации сетевого трафика между объединенными физическими сетевыми адаптерами. Affinity between virtual network adapters and physical adapters brings in flexibility to route network traffic across teamed pNICs. С помощью этой функции можно увеличить пропускную способность, сопоставляя физический адаптер с поддержкой RDMA с виртуальным адаптером с поддержкой настроек RDMA. With this feature, you can increase throughput by mapping RDMA capable physical adapter with a RDMA settings enabled vNIC. Кроме того, можно маршрутизировать конкретный тип трафика (например, динамическая миграция) на физический адаптер с более высокой пропускной способностью. Also, you can route specific type of traffic (e.g. live migration) to a higher-bandwidth physical adapter. В сценариях развертывания HCI настройка сходства позволяет использовать SMB Multichannel для обеспечения высокой пропускной способности трафика SMB. In HCI deployment scenarios, by specifying affinity, you can leverage SMB multichannel to meet high throughput for SMB traffic. Подробнее. Learn more.

Прочее Others

Поддержка для SQL Server 2019 Support for SQL Server 2019

В VMM 2019 RTM и более поздних версий теперь поддерживается SQL Server 2019. VMM 2019 RTM and later now supports SQL Server 2019.

Поддержка операционных систем Linux Support for Linux Operating system

VMM 2019 UR2 поддерживает операционные системы Linux Red Hat 8,0, CentOS 8, Debian 10, Ubuntu 20.04. VMM 2019 UR2 supports Red Hat 8.0, CentOS 8, Debian 10, Ubuntu 20.04 Linux Operating systems.

Обновления командлетов PowerShell Updates to PowerShell cmdlets

VMM 2019 UR2 включает следующие обновления командлетов для соответствующих функций: VMM 2019 UR2 includes the following cmdlet updates for the respective features:

Обновление сертификата VMM. Update VMM certificate

- Новый командлет Update-SCVMMCertificate — обновляет сертификат VMM на сервере VMM. New cmdlet Update-SCVMMCertificate — updates the VMM certificate on the VMM server.

Настройка сходства между виртуальными и физическими сетевыми адаптерами. Set affinity between virtual network adapters and physical adapters

- Новый параметр [-PhysicalNetworkAdapterName] — задает имя физического сетевого адаптера и включен в командлеты New-SCVirtualNetworkAdapter и Set-SCVirtualNetworkAdapter. New parameter [-PhysicalNetworkAdapterName] — specifies the name of the physical network adapter, and is included in New-SCVirtualNetworkAdapter and Set-SCVirtualNetworkAdapter cmdlets.

Поддержка протокола IPv6 Support for IPv6

Новый параметр [-IPv6Subnet] — задает подсеть IPv6 и включен в командлет Add-SCFabricRoleResource. New parameter [-IPv6Subnet] — specifies an IPv6 subnet, and is included in Add-SCFabricRoleResource cmdlet.

Обновления параметров в существующих командлетах: Updates to parameters in existing cmdlets:

- Адреса IPv4 и IPv6 с разделением «;» можно передавать в параметр [-RoutingIPSubnet] в командлете Add-SCVMNetworkGateway. IPv4 and IPv6 address separated by ‘;’ can be passed to [-RoutingIPSubnet] parameter in Add-SCVMNetworkGateway cmdlet.

- IPv6-адреса также можно добавить в параметр [-PublicIPAddresses] в командлете New-SCGatewayRoleConfiguration. IPv6 addresses can also be added to [-PublicIPAddresses] parameter in New-SCGatewayRoleConfiguration cmdlet.

Дополнительные сведения об этих обновлениях см. в статьях, посвященных VMM PowerShell. For more information about these updates, see VMM PowerShell articles.

Поддержка этой версии Virtual Machine Manager (VMM) прекращена. Рекомендуем перейти на VMM 2019. This version of Virtual Machine Manager (VMM) has reached the end of support, we recommend you to upgrade to VMM 2019.

Эта статья посвящена новым возможностям, поддерживаемым в System Center 1807 — Virtual Machine Manager (VMM). This article details the new features supported in System Center 1807 — Virtual Machine Manager (VMM).

Новые возможности в System Center версии 1807, Virtual Machine Manager What’s new in System Center 1807 — Virtual Machine Manager

В приведенных ниже разделах описаны новые функции, поддерживаемые в VMM 1807. See the following sections for information about the new features supported in VMM 1807.

Чтобы просмотреть ошибки, исправления и инструкции по установке для VMM 1807, см. статью базы знаний 4135364. To view the bugs fixed and the installation instructions for VMM 1807, see KB article 4135364.

Хранилище Storage

Поддержка использования общих томов кластера для размещения нового виртуального жесткого диска Supports selection of CSV for placing a new VHD

VMM 1807 позволяет выбирать общие тома кластера (CSV) для размещения нового виртуального жесткого диска (VHD). VMM 1807 allows you to select a cluster shared volumes (CSV) for placing a new virtual hard disc (VHD).

В более ранних версиях VMM, новый VHD для виртуальной машины по умолчанию размещался в том же CSV, где находились остальные виртуальные жесткие диски этой виртуальной машины, и у вас не было возможности выбрать другой CSV или другую папку. In earlier versions of VMM, a new VHD on a virtual machine (VM), by default, is placed on the same CSV where the earlier VHDs associated with the VM are placed, there was no option to choose a different CSV/ folder. В случае проблем с CSV, например при исчерпании свободного или выделенного места в хранилище, пользователям приходилось выполнять миграцию VHD-диска после его развертывания. In case of any issues related to the CSV, such as storage full or over commitment, users had to migrate the VHD, only after deploying the VHD.

В версии VMM 1807 вы можете выбрать любое расположение для нового диска. Вы можете легко управлять этим диском с учетом доступного места в хранилище CSV. With VMM 1807, you can now choose any location to place the new disc. You can manage this disc easily, based on the storage availability of CSVs. Дополнительные сведения. Learn more.

Сеть Networking

Отображение сведений об LLDP для сетевых устройств Display of LLDP information for networking devices

VMM 1807 поддерживает протокол LLDP (Link Layer Discovery Protocol). VMM 1807 supports Link Layer Discovery Protocol (LLDP). Теперь вы можете просмотреть с виртуальной машины сведения о свойствах и возможностях сетевых устройств для узлов. You can now view network device properties and capabilities information of the hosts from VMM. На узлах должна быть установлена ОС Windows 2016 или ее более новая версия. Host operating system must be Windows 2016 or higher.

Для получения свойств LLDP на узлах включены функции DataCenterBridging и DataCenterBridging-LLDP-Tools. DataCenterBridging and DataCenterBridging-LLDP-Tools features have been enabled on hosts to fetch the LLDP properties. Дополнительные сведения. Learn more.

Преобразование коммутатора SET в логический коммутатор Convert SET switch to logical switch

VMM 1807 позволяет преобразовать коммутатор SET (Switch Embedded Teaming) в логический коммутатор с помощью консоли VMM. VMM 1807 allows you to convert a switch embedded teaming (SET) switch to logical switch by using the VMM console. В более ранних версиях эта можно было сделать только в сценарии PowerShell. In earlier versions, this feature was supported only through PowerShell script. Дополнительные сведения. Learn more.

Управление узлами VMware VMware host management

VMM 1807 поддерживает серверы VMware ESXi v6.5 в структуре VMM. VMM 1807 supports VMware ESXi v6.5 servers in VMM fabric. Эта поддержка дает администраторам дополнительную гибкость в управлении несколькими используемыми гипервизорами. This support facilitates the administrators with additional flexibility in managing multiple hypervisors in use. Дополнительные сведения о поддерживаемых версиях сервера VMware см. здесь. Learn more about the additional details of supported vmware server versions.

Поддержка обновления кластера S2D Support for S2D cluster update

VMM 1807 поддерживает обновление узла или кластера S2D. VMM 1807 supports update of an S2D host or a cluster. Вы можете обновлять отдельные узлы и кластеры S2D до базовых конфигураций, настроенных в службах Windows Server Update Services (WSUS). You can update individual S2D hosts or clusters against the baselines configured in windows server update services (WSUS). Дополнительные сведения. Learn more.

Прочее Others

Поддержка SQL 2017 Support for SQL 2017

В VMM 1807 поддерживается SQL 2017. VMM 1807 supports SQL 2017. Вы можете обновить SQL 2016 до SQL 2017. You can upgrade SQL 2016 to 2017.

Поддержка этой версии Virtual Machine Manager (VMM) прекращена. Рекомендуем перейти на VMM 2019. This version of Virtual Machine Manager (VMM) has reached the end of support, we recommend you to upgrade to VMM 2019.

Эта статья посвящена новым возможностям, поддерживаемым в System Center 1801, — Virtual Machine Manager (VMM). This article details the new features supported in System Center 1801 — Virtual Machine Manager (VMM).

Эта статья посвящена новым возможностям, поддерживаемым в System Center 2016, — Virtual Machine Manager (VMM). This article details the new features supported in System Center 2016 — Virtual Machine Manager (VMM).

Новые возможности System Center 1801 — Virtual Machine Manager What’s new in System Center 1801 — Virtual Machine Manager

В следующих разделах подробно описаны новые функции, поддерживаемые в VMM 1801. See the following sections for detailed information about the new features supported in VMM 1801.

Среда выполнения приложений Compute

Вложенная виртуализация Nested virtualization

VMM поддерживает функцию вложенной виртуализации, которая позволяет запускать Hyper-V на виртуальной машине Hyper-V. VMM supports Nested Virtualization feature that allows you to run Hyper-V inside a Hyper-V virtual machine. Другими словами, с помощью вложенной виртуализации можно виртуализировать сам узел Hyper-V. In other words, with nested virtualization, a Hyper-V host itself can be virtualized. Вложенную виртуализацию можно включить по внештатному каналу, используя PowerShell и конфигурацию узла Hyper-V. Nested virtualization can be enabled out-of-band by using PowerShell and Hyper-V host configuration.

Эта возможность позволит вам снизить расходы на инфраструктуру при разработке, тестировании, демонстрации или обучении. You can leverage this functionality to reduce your infrastructure expense for development, test, demo, and training scenarios. Эта функция также позволяет выполнять в гипервизоре Майкрософт решения сторонних производителей для управления виртуализацией. This feature also allows you to use third- party virtualization management products with Microsoft hypervisor.

Функцию вложенной виртуализации можно включить или отключить с помощью SCVMM 1801. You can enable or disable the nested virtualization feature using SCVMM 1801. В VMM можно настроить виртуальную машину в качестве узла и выполнять на этой виртуальной машине функции узла. You can configure the VM as a Host in VMM and perform host operations from VMM on this VM. Например, динамическая оптимизация VMM рассматривает вложенный узел для размещения виртуальных машин. For example, VMM dynamic optimization considers a nested VM host for placement. (Learn more) Дополнительные сведения. Learn more.

Миграция виртуальной машины VMware (виртуальной машины на основе встроенного ПО EFI) в виртуальную машину Hyper-V Migration of VMware VM (EFI firmware-based VM) to Hyper-V VM

В текущей версии VMM миграция виртуальных машин VMware в Hyper-V поддерживается только для виртуальных машин на основе BIOS. The current VMM migration for VMware VMs to Hyper-V only supports migration of BIOS-based VMs.

В выпуске VMM 1801 реализована возможность миграции виртуальных машин VMware на основе EFI в виртуальные машины Hyper-V поколения 2. VMM 1801 release enables migration of EFI based VMware VMs to Hyper-V generation 2 VMs. Если вы перенесете виртуальные машины VMware на платформу Microsoft Hyper-V, для них будут действовать все преимущества и новые возможности Hyper-V поколения 2. VMware VMs that you migrate to Microsoft Hyper-V platform can take advantage of the Hyper-V generation 2 features.

В этот выпуск входит мастер преобразования виртуальной машины, который предлагает миграцию исходя из типа встроенного ПО (BIOS или EFI) и правильно выбирает поколение виртуальной машины Hyper-V. Дополнительные сведения. As part of this release, the Convert Virtual machine wizard enables the VM migration based on the firmware type (BIOS or EFI), selects and defaults the Hyper-V VM generation appropriately: Learn more.

- Виртуальные машины на основе BIOS преобразуются в виртуальные машины Hyper-V поколения 1. BIOS-based VMs are migrated to Hyper-V VM generation 1.

- Виртуальные машины на основе EFI преобразуются в виртуальные машины Hyper-V поколения 2. EFI-based VMs are migrated to Hyper-V VM generation 2.

Также мы внесли улучшения в процесс преобразования виртуальной машины VMWare, ускорив его на 50 %. We have also made improvements in the VMWare VM conversion process that makes the conversion up to 50% faster.

Повышение производительности модуля обновления узлов Performance improvement in host refresher

Модуль обновления узлов получил в VMM 1801 ряд обновлений для повышения производительности. The VMM 1801 host refresher has undergone certain updates for performance improvement.

Теперь вы заметите очевидные и значительные улучшения производительности заданий в тех ситуациях, где требуется управление большим количеством узлов и виртуальных машин с контрольными точками. With these updates, in scenarios where the organization is managing large number of hosts and VMs with checkpoints – you would be able to observe significant and noticeable improvements in the performance of the job.

В лаборатории мы добились почти 10-кратного увеличения производительности для экземпляров VMM, управляющих 20 узлами с 45–100 виртуальными машинами в каждом. In our lab with VMM instances managing 20 hosts — each host managing 45-100 VMs, we have measured up to 10X performance improvement.

Расширенный сеанс консоли в VMM Enhanced console session in VMM

Консольное подключение в VMM позволяет подключаться к виртуальной машине без удаленного рабочего стола. Console connect in VMM provides an alternative way to remote desktop to connect to the VM. Это может пригодиться, когда у виртуальной машины нет сетевых интерфейсов или вы намерены внести изменения конфигурации, которые могут нарушить сетевое подключение. This is most useful when the VM does not have any network connectivity or want to change network configuration that could break the network connectivity. В настоящее время консольное подключение в текущей версии VMM поддерживает только базовые функции сеанса и позволяет вставлять текст из буфера только через пункт меню «Ввести текст из буфера обмена». Currently, the current console connect in VMM supports only basic session where clipboard text can only be pasted through Type Clipboard Text menu option.

VMM 1801 поддерживает режим расширенного сеанса, в котором становятся доступны операции буфера обмена Вырезать (CTRL+X) , Копировать (CTRL+C) и Вставить (CTRL+V) для текста и файлов в кодировке ANSI. Это позволяет передать текст и (или) файлы на виртуальную машину или от нее через буфер обмена. VMM 1801 supports enhanced console session that enables Cut (Ctrl + X), Copy (Ctrl + C) and Paste (Ctrl + V) operations on the ANSI text and files available on the clipboard, thereby copy/paste commands for text and files are possible from and to the VM. (Learn more) Дополнительные сведения. Learn more.

Хранилище Storage

Улучшение системы качества обслуживания хранилища в VMM Improvement in VMM storage QoS

Система качества обслуживания хранилища (SQoS) позволяет централизованно отслеживать и контролировать производительность хранилища для виртуальных машин с помощью ролей Hyper-V и масштабируемого файлового сервера. Storage Quality of Service (SQoS) provides a way to centrally monitor and manage storage performance for virtual machines using Hyper-V and the Scale-Out File Server (SOFS) roles. Этот компонент автоматически улучшает равномерность распределения ресурсов хранилища между несколькими виртуальными машинами в одном кластере, позволяя задать цели производительности на основе политики. The feature automatically improves storage resource fairness between multiple VMs using the same cluster and allows policy-based performance goals.

VMM 1801 поддерживает следующие усовершенствования в системе SQoS. VMM 1801 supports the following improvements in SQoS:

- Расширение поддержки SQoS. Теперь политики качества обслуживания хранилища можно назначить не только для S2D, но и для сетей хранения данных (сетей SAN). Extension of SQoS support beyond S2D — You can now assign storage QoS policies to storage area networks (SAN). (Learn more) Дополнительные сведения. Learn more.

- Поддержка частного облака VMM. Теперь клиенты облака VMM могут использовать политики качества обслуживания хранилища. Support for VMM private cloud — storage QoS policies can now be consumed by the VMM cloud tenants. (Learn more) Дополнительные сведения. Learn more.

- Поддержка шаблонов для политики качества обслуживания хранилища. Для определения политик качества обслуживания хранилища можно использовать шаблоны виртуальных машин. Availability of storage QoS policies as templates — You can set storage QoS policies through VM templates. (Learn more) Дополнительные сведения. Learn more.

Сеть Networking

Настройка гостевых кластеров в SDN с помощью VMM Configuration of guest clusters in SDN through VMM

Настройка гостевых кластеров в Windows Server 2016 и System Center 2016 претерпела ряд изменений с появлением программно-определяемой сети (NC). With the advent of the software defined network (SDN), in Windows Server 2016 and System Center 2016, the configuration of guest clusters has undergone some change.

Теперь, когда появились сети SDN, подключенные к виртуальной сети через SDN виртуальные машины могут использовать только тот IP-адрес, который сетевой контроллер назначит для обмена данными. With the introduction of the SDN, VMs which are connected to the virtual network using SDN are only permitted to use the IP address that the network controller assigns for communication. Структура SDN основывается на структуре сети Azure и поддерживает функцию плавающего IP-адреса через программную подсистему балансировки нагрузки, как и в сетях Azure. The SDN design is inspired by Azure networking design, supports the floating IP functionality through the Software Load Balancer (SLB), like Azure networking.

Выпуск VMM 1801 поддерживает функцию плавающих IP-адресов через программную подсистему балансировки нагрузки при работе с SDN. VMM 1801 release also supports the floating IP functionality through the Software Load Balancer (SLB) in the SDN scenarios. VMM 1801 поддерживает гостевые кластеры через виртуальные IP-адреса внутренней подсистемы балансировки нагрузки. VMM 1801 supports guest clustering through an Internal Load Balancer (ILB) VIP. Внутренняя подсистема балансировки нагрузки использует порты проверки, которые создаются на виртуальных машинах в гостевом кластере для идентификации активного узла. The ILB uses probe ports, which are created on the guest cluster VMs to identify the active node. В любой момент времени на запросы внутренней подсистемы балансировки нагрузки отвечает только один узел, который считается активным, и именно на него направляется весь трафик для виртуального IP-адреса. At any given time, the probe port of only the active node responds to the ILB and all the traffic directed to the VIP is routed to the active node. . . (Learn more) Дополнительные сведения. Learn more.

Настройка виртуальных IP-адресов программной подсистемы балансировки нагрузки с шаблонов служб VMM Configuration of SLB VIPs through VMM service templates

В Windows 2016 сеть SDN может использовать программную подсистему балансировки нагрузки для равномерного распределения трафика между рабочими нагрузками, которыми управляют поставщики служб и клиенты. SDN in Windows 2016 can use Software Load Balancing (SLB) to evenly distribute network traffic among workloads managed by service provider and tenants. В настоящее время VMM 2016 поддерживает развертывание виртуальных IP-адресов программной подсистемы балансировки нагрузки с помощью PowerShell. VMM 2016 currently supports deployment of SLB Virtual IPs (VIPs) using power shell.

В выпуске VMM 1801 поддерживается настройка виртуальных IP-адресов программной подсистемы балансировки нагрузки с помощью шаблонов служб при развертывании многоуровневого приложения. With VMM 1801, VMM supports configuration of SLB VIPs while deploying multi-tier application by using the service templates. (Learn more) Дополнительные сведения. Learn more.

Настройка зашифрованных сетей виртуальных машин через VMM Configuration of encrypted VM networks through VMM

VMM 1801 поддерживает шифрование для сетей виртуальных машин. VMM 1801 supports encryption of VM networks. С помощью нового компонента зашифрованных сетей можно легко настроить полное шифрование для сетей виртуальных машин с использованием сетевого контроллера. Using the new encrypted networks feature, end-to-end encryption can be easily configured on VM networks by using the Network Controller (NC). Такое шифрование устраняет риск неавторизованной утечки или изменения трафика между двумя виртуальными машинами в одной сети и одной подсети. This encryption prevents traffic between two VMs on the same network and same subnet, from being read and manipulated.

Управление шифрованием выполняется на уровне подсети, и можно отдельно включить или отключить шифрование для каждой подсети в сети виртуальных машин. The control of encryption is at the subnet level and encryption can be enabled/disabled for each subnet of the VM network. (Learn more) Дополнительные сведения. Learn more.

Безопасность Security

Поддержка экранированной виртуальной машины Linux Support to Linux shielded VM

В Windows Server 2016 реализована концепция экранированной виртуальной машины для виртуальных машин Windows. Windows Server 2016 introduced the concept of a shielded VM for Windows OS-based VMs. Экранированные виртуальные машины защищают хранимые данные от вредоносных действий администратора и от недоверенного программного обеспечения, выполняемого на узлах Hyper-V. Shielded VMs provide protection against malicious administrator actions both when VM’s data is at rest or an untrusted software is running on Hyper-V hosts.

В Windows Server версии 1709 для Hyper-V появилась поддержка подготовки экранированных виртуальных машин Linux, а теперь она перенесена и в VMM 1801. With Windows Server 1709, Hyper-V introduces support for provisioning Linux shielded VMs and the same has been extended to VMM 1801. (Learn more) Дополнительные сведения. Learn more.

Настройка резервной HGS Configuration of fallback HGS

Служба защиты узла (HGS) служит основой для служб аттестации и защиты ключей, необходимых для выполнения экранированных виртуальных машин на узлах Hyper-V, поэтому она должна работать даже в случае аварии. Being at the heart of providing attestation and key protection services to run shielded VMs on Hyper-V hosts, the host guardian service (HGS) should operate even in situations of disaster. В Windows Server 1709 добавлена поддержка резервной HGS. Windows Server 1709 added support for fallback HGS.

VMM 1801 позволяет настроить для защищенного компьютера сразу две пары (URI аттестации и защиты ключей) URL-адресов HGS — основную и дополнительную. Using VMM 1801, a guarded host can be configured with a primary and a secondary pair of HGS URLS (an attestation and key protection URI). Эта возможность позволяет реализовать такие сценарии, как развертывание защищенной структуры сразу в двух центрах обработки данных с возможностью аварийного восстановления, выполнение HGS на экранированной виртуальной машине и т. д. This capability enables scenarios such as guarded fabric deployments spanning two data centers for disaster recovery purposes, HGS running as shielded VMs etc.

Всегда будут использоваться основные URL-адреса HGS, пока они доступны. The primary HGS URLs will always be used in favor of the secondary. Если основная служба HGS не сможет ответить по прошествии установленного времени ожидания и количества повторных попыток, выполняется попытка обращения к дополнительной службе. If the primary HGS fails to respond after the appropriate timeout and retry count, the operation will be reattempted against the secondary. При всех последующих обращениях всегда предпочитается основная служба, а дополнительная используется лишь в случае сбоя основной. Subsequent operations will always favor the primary; the secondary will only be used when the primary fails. (Learn more) Дополнительные сведения. Learn more.

Интеграция с Azure Azure Integration

Управление подписками Azure на основе Azure Resource Manager и региона Management of Azure Resource Manager-based and region-specific Azure subscriptions

В настоящее время подключаемый модуль Azure для VMM поддерживает только классические виртуальные машины и общедоступные регионы Azure. Currently, the VMM Azure plugin supports only classic virtual machines (VMs) and public Azure regions.

VMM 1801 позволяет управлять виртуальными машинами на основе Azure Resource Manager с поддержкой аутентификации на основе Azure Active Directory (AD), которые создаются с помощью нового портала Azure и подписок Azure на основе региона (для Германии, Китая и государственных организаций США). VMM 1801 supports management of Azure Resource Manager based VMs, Azure Active Directory (AD) based authentication that is created by using the new Azure portal and region-specific Azure subscriptions (namely, Germany, China, US Government Azure regions). (Learn more) Дополнительные сведения. Learn more.

Новые возможности VMM 2016 What’s new in VMM 2016

В приведенных ниже разделах подробно описаны новые функции, поддерживаемые в VMM 2016. See the following sections for detailed information about the new features supported in VMM 2016.

Среда выполнения приложений Compute

Управление полным жизненным циклом узлов и виртуальных машин под управлением Nano Server Full lifecycle management of Nano Server-based hosts and VMs

В структуре VMM можно распределять узлы и виртуальные машины на базе сервера Nano Server и управлять ими. You can provision and manage Nano Server-based hosts and virtual machines in the VMM fabric. (Learn more) Дополнительные сведения. Learn more.

Последовательное обновление кластеров узлов Windows Server 2012 R2 Rolling upgrade of a Windows Server 2012 R2 host clusters